人类注定要打破机器人三大定律

人类注定要打破机器人三大定律

阿西莫夫的指导方针是否像看起来那么重要?

机器人三大定律是一个备受喜爱的科幻概念。由机器人作家艾萨克·阿西莫夫于 1942 年创建,虚构的规则被认为是创造有益于人类的机器人的指南。

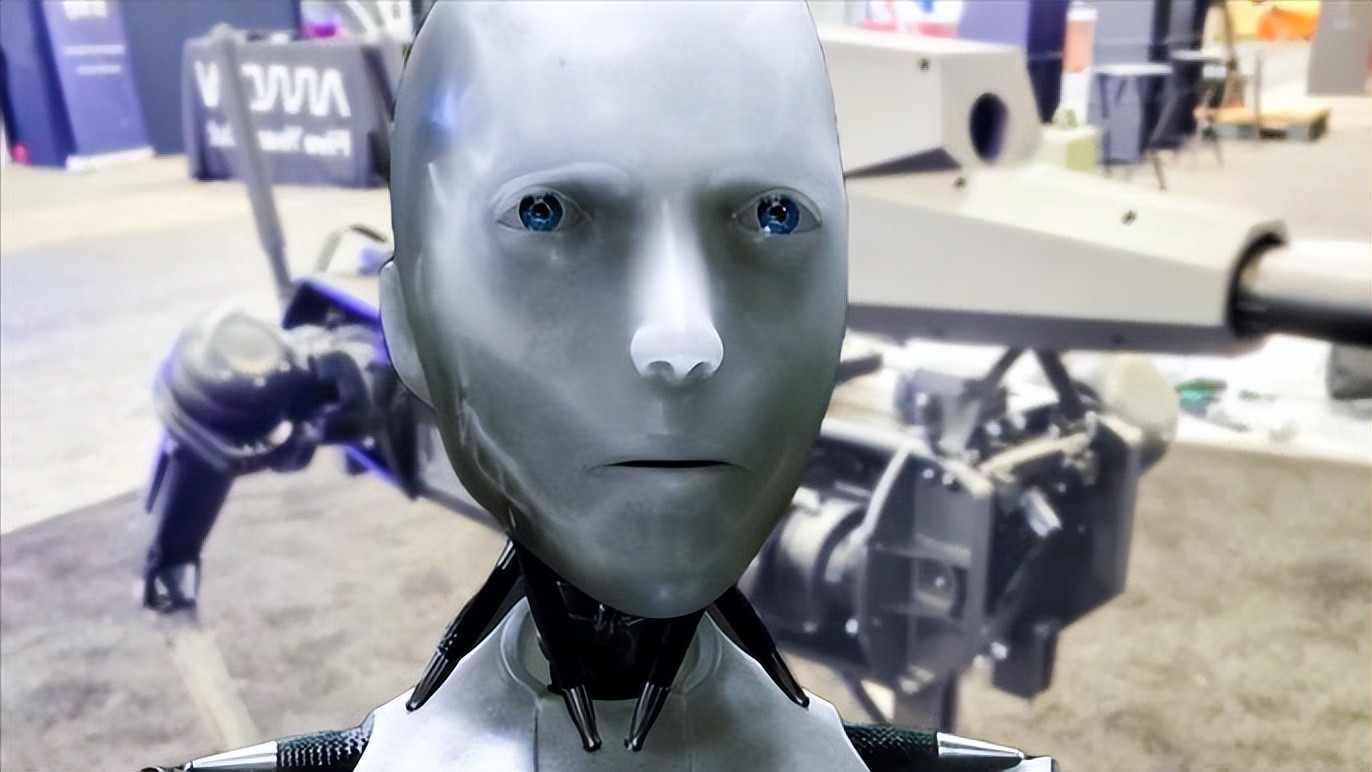

随着Tesla Bot 等产品试图将家用人形机器人商业化,这些法律比以往任何时候都更加重要。然而,像往常一样,人类已经看到了科幻小说的警示故事,并且完全避免了它。

机器人三大定律是什么?

在阿西莫夫 1942 年的短篇小说 Runaround(后来发表在 I, Robot)中,机器人三定律是所有有意识的机器人最遵循的规则。这些规则旨在使机器人服从于人类,并保护人类免受机器人可能带来的任何伤害。

规则如下:

机器人不得伤害人类,或因不作为而让人类受到伤害。机器人必须服从人类的命令,除非这些命令与第一定律相冲突。机器人必须保护自己的存在,只要这种保护不与第一或第二定律相冲突。

这些规则在阿西莫夫的原始故事中已经被视为不稳定的。在故事中,机器人 SPD-13 正在帮助恢复为采矿站提供生命支持的光电池组。为此,SPD-13 必须检索 Selenium。

然而,在到达 Selenium 后,SPD-13 意识到 Selenium 对他来说很危险。在执行任务之前,机器人的规则被修改以加强规则 3,因为机器太昂贵而不能丢失。当机器人看到危险,不能违背它的直接命令,它的任务失败会导致人类受到伤害,它的人工智能大脑停滞不前,无法继续。

这些规则是否用于机器人和人工智能开发?

近 80 年来,阿西莫夫的机器人三定律一直被提出作为机器人和人工智能发展的指导方针。然而,随着这两个领域变得更加复杂和多样化,这些规则正在被淘汰。

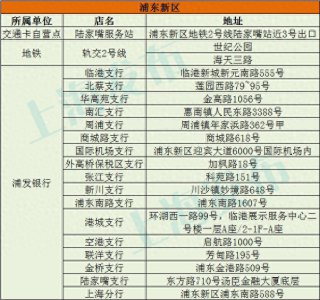

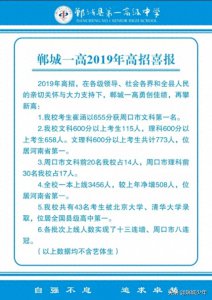

例如,2011 年和 2011 年,工程与物理科学研究委员会 (EPSRC) 和艺术与人文研究委员会制定了修订后的规则集。该指南由 5 条规则和 7 条信息组成,声称机器人不应被设计用来杀人,应实现人类目标,应促进自身安全,不应在情感上操纵人类或与人类无法区分。

机器人法则也进入了人工智能的发展。2016 年,微软 CEO Satya Nadella 透露了公司的 AI 规则。作为世界上最大的公司之一,微软的指导方针可能被视为最具影响力的。它们如下:

人工智能必须旨在帮助人类”,这意味着需要尊重人类的自主权。“人工智能必须是透明的”意味着人类应该知道并且能够理解他们是如何工作的。“人工智能必须在不损害人的尊严的情况下最大限度地提高效率”。“人工智能必须为智能隐私而设计”,这意味着它通过保护他们的信息来赢得信任。“人工智能必须具有算法责任,以便人类能够消除意外伤害”。“人工智能必须防止偏见”,这样他们就不能歧视人。

机器人定律被忽视

尽管它们在伦理讨论和流行文化中享有盛誉,但机器人的三项定律却被完全忽视了——这是有目的的。作为一个从未被合法化的规则集,这些指导方针不必被遵循,这意味着它们永远不会被遵循。

例如:主要规则——机器人不得伤害人类,或因不作为而允许人类受到伤害——正在严重违反。对于自动无人机、背装式步枪的机器狗和未来为战争而设计的机器人,这条指导方针很可能永远不会被遵循。

即使是微软的 AI 法规(由一家公司利用 AI 谋利而制定的一套规则)也无法遵循,至少其竞争对手无法遵循。最后一条规则,防止偏见,是每个主要 AI 平台的一个大问题,从 GPT-3 到 GAN 再到Facebook 的新 AI,Meta AI 研究人员认为它是无法使用的种族主义和有害的。

然而,并没有做太多的事情来解决这个问题。在“杀手机器人”方面,有一些抗议者,包括联合国的抗议者。然而,由于美国、中国和俄罗斯等国家拒绝放弃杀手机器人,因此执行第一条规则是不可能的。

对于人工智能来说,这在谷歌等公司解雇人工智能伦理研究人员的情况下更加令人震惊,这些研究人员强调了当前有偏见的人工智能的危险。

为什么人类注定要打破规则

人类注定要打破机器人三法则有两个原因:金钱和权力。机器人产业在工业、军事甚至商业领域的规模都在膨胀。

随着 Tesla Bot 和机器人宠物的目标是成为日常生活的一部分,这些法律比以往任何时候都更加不可或缺。然而,如果人工智能驱动的自动驾驶汽车仍然无法决定是否撞到人群中,我们如何相信人工智能驱动的商用机器人在任务中保持公正?